出处:CVPR2019 (oral)

bicubic SR 的 SOTA

motivation

现有的SISR方法专注于更宽更深的结构设计,而忽略了挖掘中间层特征之间的相关性。本文受启发于ICCV 2017一篇做识别分类的文章(利用了二阶统计信息),提出了一个深度二阶注意力网络SAN 以获得更好的特征表达和特征相关性学习。特别地,提出了一个二阶通道注意力机制SOCA来进行相关性学习。同时,提出了一个non-locally增强残差组NLRG来捕获长距离空间内容信息。性能方面取得了SISR最好的结果。

contribution

- 设计了一个利用了二阶统计信息的网络:second-order attention network (SAN)

- 特别的,SAN网络包含second-order channel attention (SOCA)模块

- 然后还结合了non-locally enhanced residual group (NLRG)来捕获长距离空间内容信息。

Method

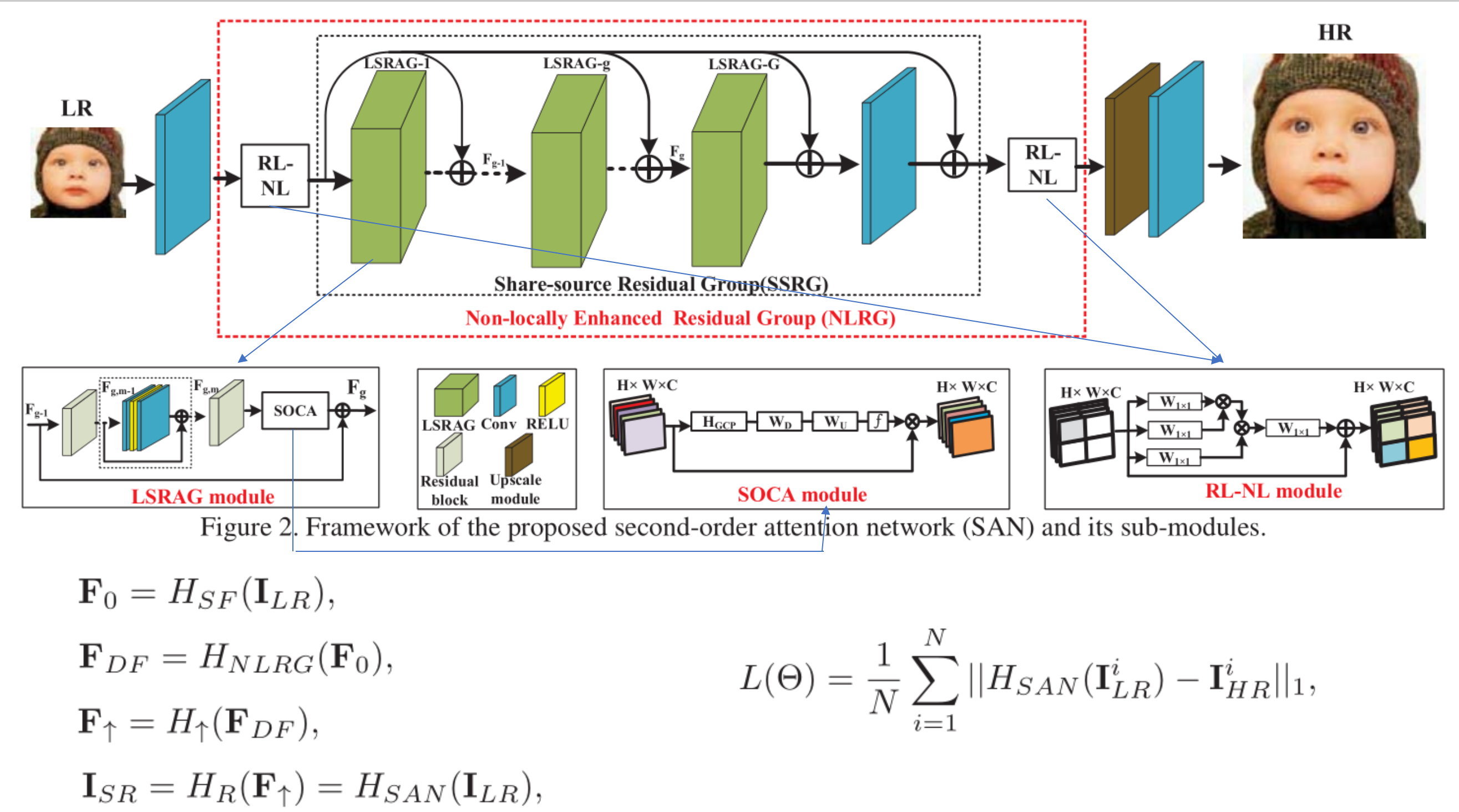

RL-NL模块

non-local模块是用来在high-level任务中捕获整幅图像的长范围依赖的。但是,全局non-local操作可能会受限于:

1)全局non-local操作需要大量的计算量; 2)对于low-level的任务来说,在一定的区域范围中进行non-local操作是更有效的

所以在SAN里,将图像划为k*k个region, 在每个region中进行non-local 操作,RL-NL充分利用LR feature的结构关联

LSRAG模块

每一个同源残差组结构(SSRG)包括G 个局部模块LSRAG加上一个同源残差连接结构SSC,简单的LSRAG堆叠不能取得更好的性能,于是加入SSC(share-source skip connections),使LR的低频信息通过,且利用训练。

所谓同源残差连接,就是把LR的特征加到每个group的输入x中,这种连接不仅可以帮助深度CNN的训练,同时还可以传递LR图像中丰富的低频信息给high-level的层。

Wssc是一个可学习参数,一开始被设置为0。对于每个group来说,都会收到SSC传递过来的F0

每个LSRAG包括M个简单的residual blocks 和local source skip connection,最后还包含一个二阶channel attention 模块(second-order channel attention module)

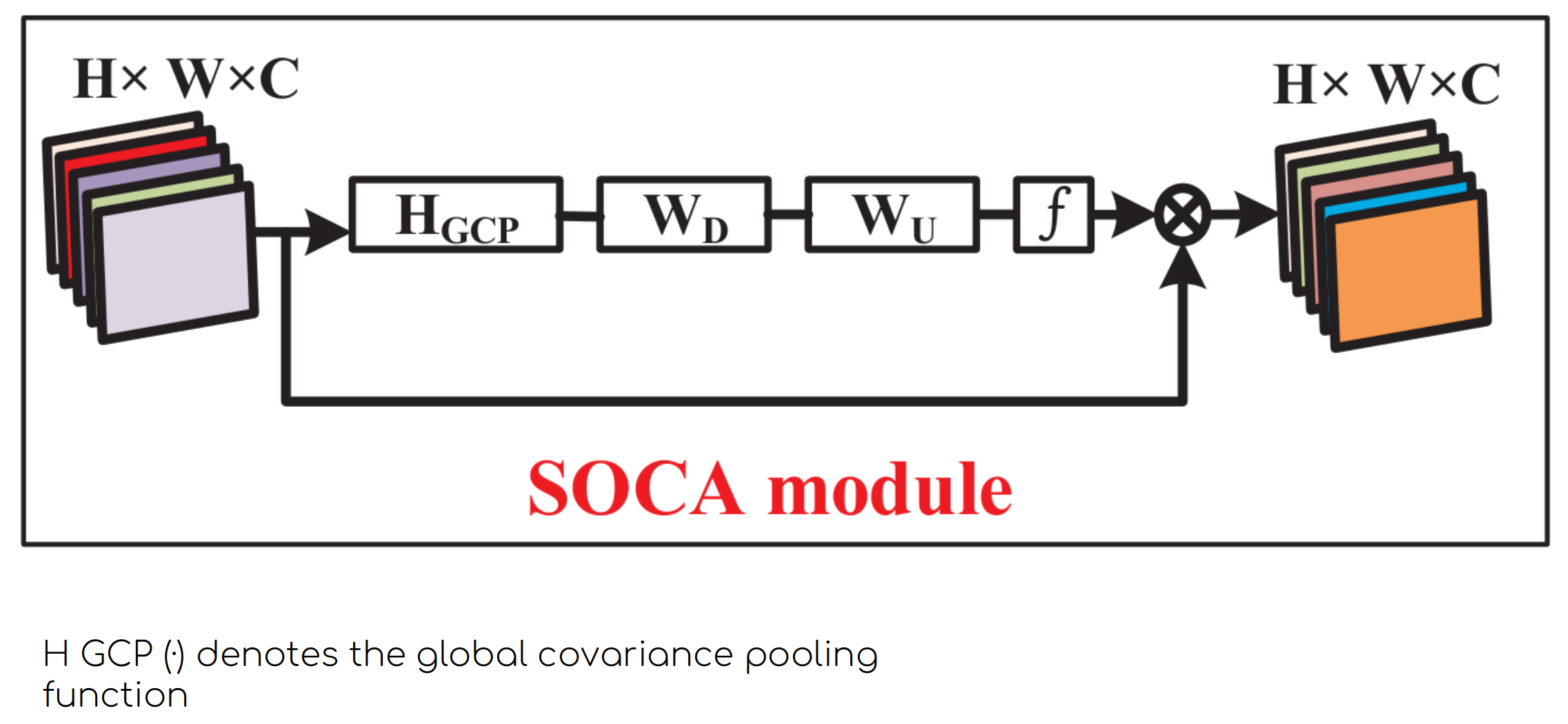

在LSRAG模块最后有一个二阶channel attention 模块,这是本文的重点

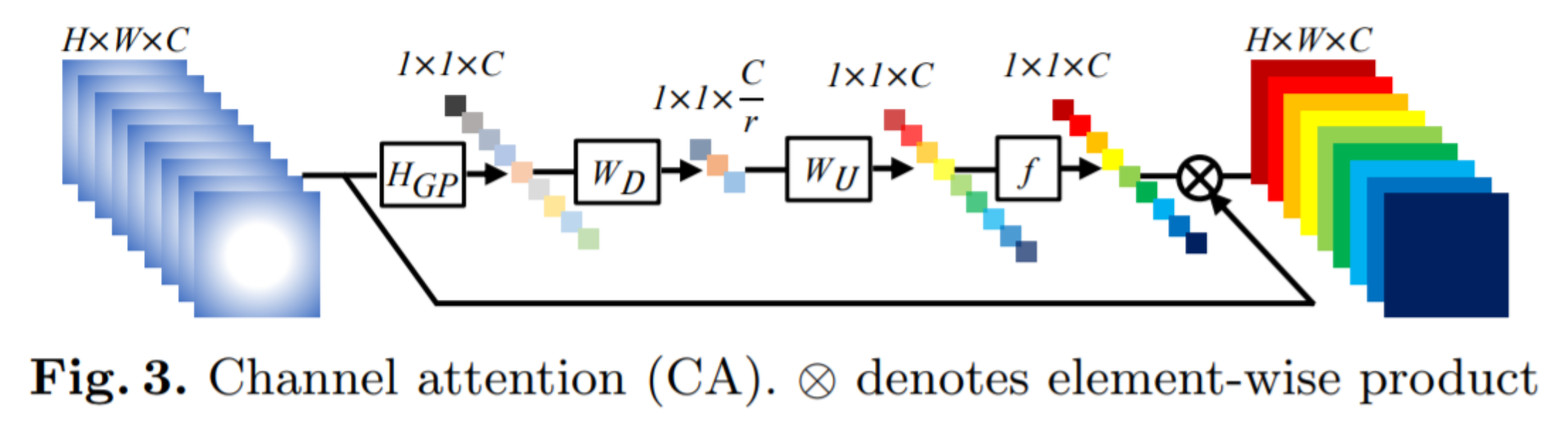

关于channel attention

RCAN中:

如上图所示,输入是一个 H×W×C 的特征,我们先进行一个空间的全局平均池化得到一个 1×1×C 的通道描述。接着,再经过一个下采样层和一个上采样层得到每一个通道的权重系数,将权重系数和原来的特征相乘即可得到缩放后的新特征,整个过程实际上就是对不同通道的特征重新进行了加权分配。

其中,下采样和上采样层都利用 1×1 的卷积来实现,下采样层的通道数减少 r 倍,f 是激活函数 sigmoid

文本的二阶channel attention和RCAN的channel attention的区别在于将 全局平均池化 替代为全局协方差池化。

文本的二阶channel attention和RCAN的channel attention的区别在于将 全局平均池化 替代为全局协方差池化。

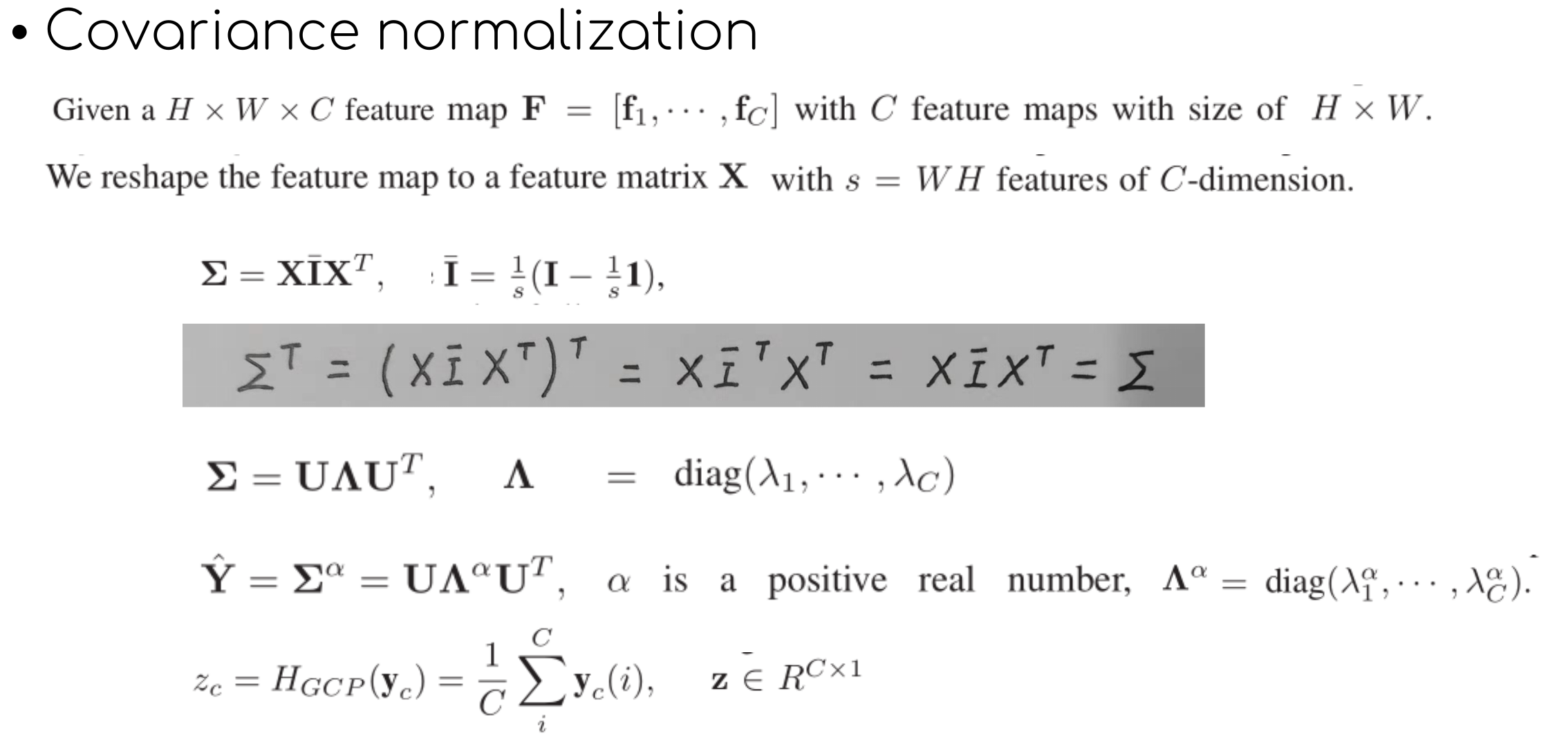

协方差归一化(就是所谓的二阶)

协方差可以用来描述变量之间的相关性,所以对于HxWxC的特征,reshape为WH(C个维度),可以用协方差矩阵描述C个通道之间的相关性。

$I$和1分别是sxs的单位矩阵和全1矩阵。因为这个协方差矩阵是个实对称矩阵,实对称矩阵必可由正交矩阵对角化,可对协方差矩阵作特征值分解,U为正交矩阵,Λ为对角阵,对角元素为特征值,按非增顺序排列。再对协方差做正则化,因为协方差的正则化对表示特征非常重要。Alpha=0.5

在具体实现上,在SSRG模块里包含20个LSRAG,和一前一后共两个region-level non-local模块,RL-NL中将图像分为2*2的region,在每个LSRAG里用了10个residual blocks.

上采样模块用的是sub-pixel上采样。

Results

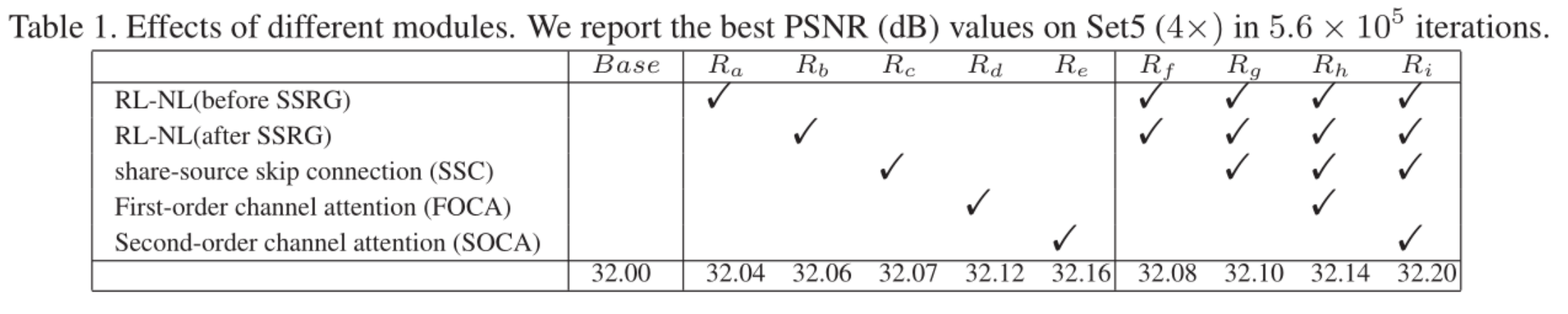

ablation study

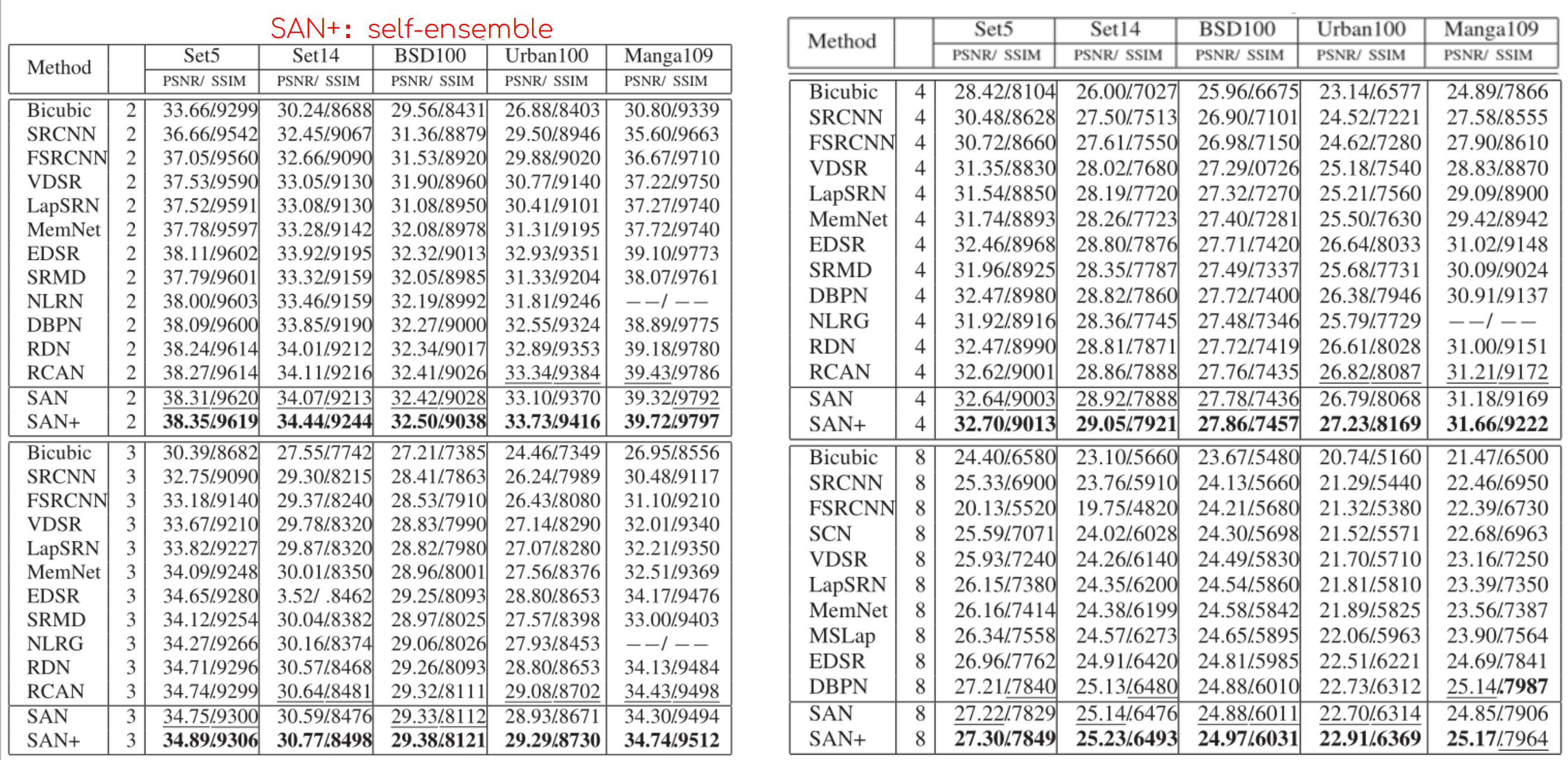

与其他SR方法对比

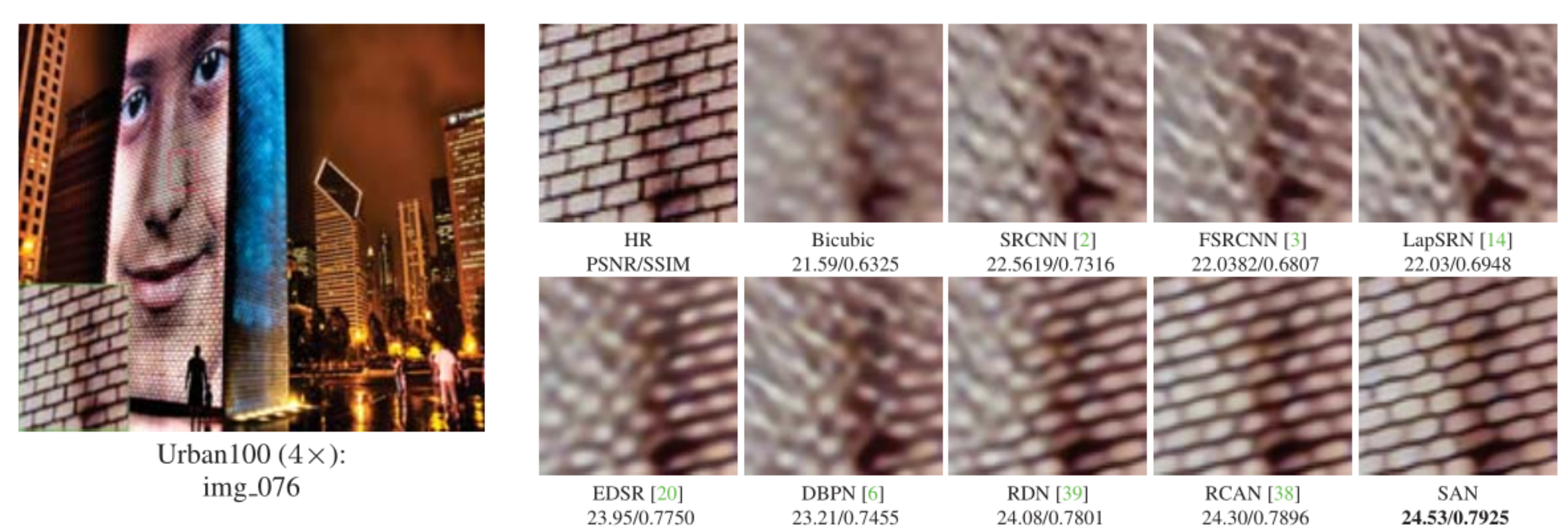

这个是视觉上的比较,对于丰富复杂的纹理,SAN能更好的恢复